Forum vom Cleef Chat

NEUES THEMA

NEUES THEMA

Gepostet am 2024.01.20, 16:10 Uhr

Gepostet am 2024.01.20, 16:10 Uhr  49 Besuche

49 Besuche

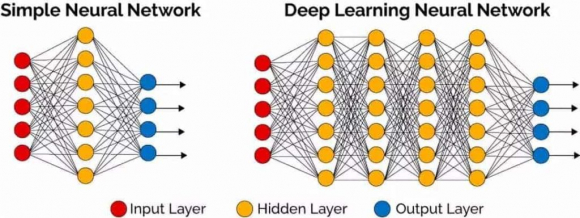

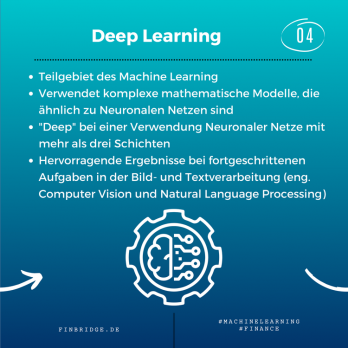

Die rasante Entwicklung digitaler Technologien hat in den letzten Jahren zu einem bemerkenswerten Anstieg von Deepfake-Anwendungen geführt. Der Begriff "Deepfake" setzt sich aus den Wörtern "deep learning" und "fake" zusammen und bezieht sich auf die Verwendung von künstlicher Intelligenz, insbesondere maschinellem Lernen, um täuschend echte manipulierte Medieninhalte zu erstellen. Die Popularität von Deepfake-Technologien ist eng mit dem Fortschritt im Bereich der neuronalen Netzwerke verbunden.

Ursprung und Entwicklung Deepfake-Technologien haben ihren Ursprung in der Forschung und Entwicklung von Generative Adversarial Networks (GANs), einem Ansatz des maschinellen Lernens, bei dem zwei neuronale Netzwerke miteinander konkurrieren – eines erstellt, das andere analysiert und verbessert. Diese Methode wurde erstmals 2014 von Ian Goodfellow und seinen Kollegen vorgestellt. In den folgenden Jahren wurde die Technologie weiter verfeinert, wobei die Verfügbarkeit großer Datensätze und leistungsfähiger Rechenressourcen den Fortschritt beschleunigten.

Populäres Aufkommen:

Die breite Öffentlichkeit wurde erstmals im Jahr 2017 auf Deepfake aufmerksam, als synthetische Videos mit hochkarätigen Persönlichkeiten in sozialen Medien und Online-Plattformen auftauchten. Insbesondere das Deepfake-Tool namens "FakeApp" erleichterte die Erstellung manipulierter Videos für jedermann, was zu einer verstärkten Verbreitung und Nutzung führte. Prominente Persönlichkeiten wurden oft als Ziel ausgewählt, was zu erheblichen Diskussionen über die ethischen und rechtlichen Implikationen führte.

Technologische Herausforderungen und Fortschritte Die rasche Verbreitung von Deepfake-Technologien hat die Notwendigkeit betont, effektive Gegenmaßnahmen zu entwickeln. Forscher arbeiten an Methoden zur Identifizierung von Deepfakes, wobei fortschrittliche Algorithmen und künstliche Intelligenz eingesetzt werden, um authentische von manipulierten Inhalten zu unterscheiden. Trotzdem bleibt die Entwicklung von Gegenmaßnahmen eine kontinuierliche Herausforderung.

Schlussfolgerung:

Deepfake-Technologien sind ein faszinierendes Beispiel für den rasanten Fortschritt in der künstlichen Intelligenz, der jedoch auch ernsthafte Bedenken hinsichtlich Missbrauchs und Manipulation aufwirft. Die Einführung von Richtlinien, Gesetzen und Technologien zur Erkennung von Deepfakes wird entscheidend sein, um den verantwortungsbewussten Einsatz dieser Technologien zu fördern und die möglichen negativen Auswirkungen zu minimieren.

Link kopieren

gefiel durch: -NETTY-, Aksuamun, Buzlumbe, FlammenHerz, Heart Angel, Shadow Moon, Usuri, Vampi, white

gefiel durch: -NETTY-, Aksuamun, Buzlumbe, FlammenHerz, Heart Angel, Shadow Moon, Usuri, Vampi, white Gepostet am 2024.01.20, 20:14 Uhr

Gepostet am 2024.01.20, 20:14 Uhr

Deepfake-Technologien, die auf GANs basieren, populär wurden. Diese ermöglichen die Generierung realistisch aussehender, jedoch falscher Medieninhalte, insbesondere gefälschter Videos.

Ja, mit fortschreitender KI-Technologie wurden auch Stimmenklonungstechnologien entwickelt. Diese Systeme können eine menschliche Stimme aufzeichnen, analysieren und dann in der Lage sein, Texte mit dieser Stimme auf eine täuschend echte Weise wiederzugeben.

Ein bekanntes Beispiel ist Tacotron, ein Text-to-Speech-System, das auf neuronalen Netzwerken basiert. Es gibt auch andere Modelle und Algorithmen, die für ähnliche Zwecke verwendet werden können.

Ich empfehle dir das als Themenvorschlag einzustellen!

*Generative Adversarial Networks (GANs

Generator: Erzeugt Daten, zum Beispiel Bilder, die möglichst realistisch aussehen sollen.

Diskriminator: Beurteilt, ob die erhaltenen Daten vom Generator echt oder künstlich sind.

Während des Trainings versucht der Generator, immer realistischere Daten zu erstellen, während der Diskriminator versucht, zwischen echten und generierten Daten zu unterscheiden. Dieser Wettbewerb führt dazu, dass der Generator realistischere Daten generiert.

😄 Für desinteressierte..äh interessierte..

Link kopieren

Gepostet am 2024.01.20, 20:43 Uhr

Gepostet am 2024.01.20, 20:43 Uhr

Gefällt mir das Forum

Hier ein paar Informationen aus der Quelle von www.lmz-bw.de

Durch die rasante Weiterentwicklung der Deepfake-Technologie in den letzten Jahren sind heutzutage verschiedene technische Manipulationen möglich. Hier stellen wir euch die [color=#000000]bekanntesten Arten von Deepfakes kurz vor:

[/color]

- Face-Swap: Der Klassiker – hier wird das [color=#000000]Gesicht einer Person in einem Bild oder Video durch das Gesicht einer anderen Person ersetzt.[/color]

- Audio-Deepfake: Die Stimme einer Person wird [color=#000000]synthetisch nachgestellt. So können Aussagen in Videos gefälscht werden.[/color]

- Puppet-Master: In einem Video wird die Mimik und Kopfbewegung der gezeigten Person manipuliert. Dafür werden die Gesten und die Stimme einer anderen Person auf die Person im Video übertragen.

- Lip-Syncing: Die Lippenbewegungen einer Person in einem Video werden manipuliert. Es entsteht der Eindruck, dass die Person die Worte spricht, obwohl sie tatsächlich von einer anderen Quelle stammen.

- Gesichtssynthese: Es werden künstliche realistische Gesichter erstellt, die es auf der Welt nicht gibt. Solche Gesichter können auf folgender Webseite abgerufen werden: [color=#000000]https://thispersondoesnotexist.com/[/color]

Link kopieren

Gepostet am 2024.01.27, 09:32 Uhr

Gepostet am 2024.01.27, 09:32 Uhr

Rasante Entwicklung??? Nein eher schleppend, denn was nützt ein die Software wenn man die teuerste Hardware braucht für EINE EINZIGE Funktion/Aufgabe?

Also die heutigen Grafik-Karten Onboard können schon viel, warum orientiert sich der Entwickler nicht an diesen Lösungen?

Somit Geldverschwendung, aber nett das es erwähnt wurde als Thema.

Link kopieren

Gepostet am 2024.01.28, 10:06 Uhr

Gepostet am 2024.01.28, 10:06 Uhr

Ich habe mich sowohl am Threaderöffner, als auch an dein Beitrag orientiert.

Teils bin ich dabei auf undokumentierte Dinge gestoßen. Wie eben die Software "Deepfake".

Also wenn du meinst, mein Thema geht dran vorbei, kann ich dir nicht zustimmen. Du bist ja auch nur mit dein Letzten Beitrag zur Software eingegangen.

Meine Meinung zu solch Ki-Tools:

Das gehört einfach verboten, solche Tools sind eine Gefahr für alle.

Link kopieren

gefiel durch: -NETTY-

gefiel durch: -NETTY- Gepostet am 2024.01.28, 13:46 Uhr

Gepostet am 2024.01.28, 13:46 Uhr

Die Erstellung von Deepfakes erfordert in der Regel leistungsstarke Hardware, insbesondere Grafikprozessoren (GPUs). Hier sind einige allgemeine Hardware-Anforderungen:

GPU: Eine leistungsfähige GPU ist entscheidend, da Deepfake-Algorithmen oft auf parallelen Berechnungen basieren. Hochwertige GPUs von Unternehmen wie NVIDIA (z. B. GeForce RTX-Serie) werden häufig verwend

CPU: Eine starke CPU ist ebenfalls wichtig, obwohl die GPU die Hauptlast trägt. Ein Mehrkernprozessor kann bei bestimmten Aspekten des Deepfake-Prozesses nützlich sein.

RAM: Ausreichend RAM ist notwendig, um große Mengen an Daten effizient zu verarbeiten. 16 GB oder mehr sind für komplexe Deepfake-Anwendungen empfehlenswert.

Speicherplatz: Da Deepfake-Modelle oft groß sind, wird ausreichender Speicherplatz benötigt. SSDs sind aufgrund ihrer schnellen Lese- und Schreibgeschwindigkeiten vorteilhaft.

Für Anfänger gibt es auch cloudbasierte Dienste, die den Zugriff auf leistungsstarke Hardware ohne die Notwendigkeit einer eigenen teuren Ausstattung ermöglichen.

Link kopieren

Gepostet am 2024.01.28, 20:25 Uhr

Gepostet am 2024.01.28, 20:25 Uhr

Nochmal zum mitlesen und klarstellen:

1. Ich hab den Thread gelesen.

2. Bin davon ausgegangen das es sich um eine downloadbare OFFLINE Software handelt.

3. Nicht jeder möchte seine Daten überall preisgeben, nur, um an eine virtuelle Maschine zu gelangen.

Insgesamt ein tolles Thema, und ich bleib bei meiner Meinung.

Link kopieren

Gepostet am 2024.01.29, 15:21 Uhr

Gepostet am 2024.01.29, 15:21 Uhr

Wer sich mit der Entwicklung von Machine-Learning- und KI-Systemen beschäftigten möchte, braucht eine Menge Übung und gewisse Fähigkeiten im Bereich KI. Letztere sind in vielerlei Hinsicht eine Frage der persönlichen Charaktereigenschaften.

Wer sich mit der Entwicklung von Machine-Learning- und KI-Systemen beschäftigten möchte, braucht eine Menge Übung und gewisse Fähigkeiten im Bereich KI. Letztere sind in vielerlei Hinsicht eine Frage der persönlichen Charaktereigenschaften.

Übung allerdings lässt sich aufbauen, und dabei können einige kostenlose Gratis-Plattformen und Tools für die KI-Entwicklung helfen. Dabei geht es auch darum,herumzuexperimentieren und KI-Software nicht von Grund auf neu modellieren zu müssen.

OpenAI Gym

ist eine von Microsoft und Elon Musk unterstützte Initiative, die dabei helfen soll, künstliche Intelligenz zu einem nützlichen Helfer für die Menschheit zu entwickeln.

Google TensorFlow Google stellt ebenfalls eine kostenlose KI-Plattform für Entwickler zur Verfügung:

Microsoft Cognitive Toolkit Hocheffizient und auf Skalierbarkeit getrimmt – so lässt sich das Microsoft Cognitive Toolkit, kurz CNTK, am besten beschreiben. Um das zu gewährleisten, ist das Framework natürlich für den Einsatz auf Microsofts Azure optimiert.

PyTorch Auch PyTorch stammt ursprünglich von einem der großen Player: Von Facebook-Ingenieuren aus der bereits seit 2002 existierenden Torch-Umgebung entwickelt, hat sich das Open-Source-Framework inzwischen zu einem der Standard-Tools für die KI-Entwicklung gemausert.

Shogun Bei Shogun handelt es sich um eine Open-Source-Library für KI-Entwicklung unter GPLv3-Lizenz. Die unter C++ verfasste Toolbox bietet Entwicklern eine Vielzahl von Werkzeugen, um Machine-Learning-Anwendungen zu gestalten.

FluxML FluxML ist ein Machine-Learning-Framework unter MIT-Lizenz. Es bezeichnet sich selbst als das „elegantes Machinen Learning Stack“ und wird deshalb gerne von KI-Forschern zur Hand genommen, weshalb auch namhafte Universitäten bei dem Projekt beteiligt sind.

Apache Mahout Die Apache-Foundation ist vor allem für ihren Webserver bekannt. Allerdings gibt es mit Mahout auch ein KI-Framework, das sich vor allem für die Entwicklung statistischer und mathematischer Machine-Learning-Anwendungen eignet. Möglich wird das durch die Verwendung linearer Algebra, wodurch mit wenigen Zeilen Code eine erhebliche Effekte erzielt werden können.

Mahout setzt durch Java als Basis außerdem auf die Skalierbarkeit der entwickelten Anwendungen. Anders als andere ML-Toolkits kommt Mahout allerdings mit einer eigenen, R-ähnlichen Sprache, ohne andere Sprachen zu übersetzen, was die Konvertierung vorhandener Lösungen erschweren kann.

Deeplearning4j Ebenfalls auf Java basiert Deeplearning4j und kann für die Entwicklung von Deep-Learning-Anwendungen und neurale Netzwerke eingesetzt werden. Durch seinen effizienten Umgang mit verteiltem Rechnen per CPU und GPU via Spark und Hadoop ist es möglich, hier besonders leistungsstarke und gut skalierbare Algorithmen zu entwickeln.

scikit-learn Die Machine-Learning-Bibliothek scikit-learn basiert auf Python und bietet sich vor allem für die vorhersagende Datenanalyse an: Verschiedene Algorithmen zur Klassifizierung und Sortierung von Daten sind an Bord, die ganze Bibliothek ist darauf optimiert, mit Python und den zugehörigen wissenschaftlichen Bibliotheken NumPy und SciPy zusammen zu arbeiten. Dadurch, und weil es im Lehreinsatz beliebt ist, gehört scikit-learn zu den wichtigsten und interessantesten Tools für die KI-Entwicklung.

Ernsthaft:

Diese und unzählige weitere Anwendungen sind erforderlich um selbständig eine brauchbare Umgebung zu schaffen die es ermöglichen kann selbständig aus Code und Performance Ergebnisse zu erzielen...

Shadow hat bereits alles dazu geschrieben.!

Das fertige Produkt ist unter Edge im Browser frei für jeden.

Ganz einfach erklärt:

Du benötigst keine Super Rechenmaschine, sondern einfach machen lassen, und das Ergebnis kommt sofort zum kopieren,sogar mit den ältesten Geräten funktioniert es tadellos 🤗

© Buzi * ^Anbieter von Entwicklungswerkzeugen stolpern übereinander in ihren Bemühungen, auf Biegen und Brechen KI-gestützte Tools zu veröffentlichen. In der Abbildung: die öffentliche Vorstellung von Amazon CodeWhisperer.

Link kopieren

Gepostet am 2024.02.19, 16:02 Uhr

Gepostet am 2024.02.19, 16:02 Uhr

Buzi mir raucht gerade der Kopf was du alles weißt. Ich staune immer wieder wie du dich hier im Forum einbringst. Alle Achtung mach weiter so LG Usuri

Link kopieren